Pourquoi les modèles d’IA génériques échouent — et pourquoi cela est particulièrement dangereux dans le domaine juridique (Watson.ch)

Basé sur une analyse suisse récente (watson.ch)

https://www.watson.ch/!669651522

Une nouvelle analyse en Suisse montre clairement que de nombreux modèles d’IA tirent leurs informations de sources opaques et parfois douteuses. Les utilisateurs ne savent pas d’où proviennent les affirmations — ni si elles sont correctes. L’enquête met en évidence plusieurs problèmes majeurs, particulièrement critiques dans le domaine juridique :

1. L’IA invente des sources ou utilise des données peu fiables

Les modèles testés ont fourni des réponses basées sur des sources fausses, inventées ou difficilement traçables.

👉 Dans le domaine juridique, ce serait fatal : une source incorrecte = une mauvaise réponse juridique = un risque de responsabilité.

2. Les modèles se contredisent

Selon la formulation de la question, les systèmes d’IA donnaient des réponses différentes et contradictoires.

👉 En droit, cela crée une insécurité totale — une loi ou un arrêt ne change pas en fonction de la formulation.

3. Manque de transparence : l’utilisateur ne sait pas ce qui est vrai

L’analyse montre qu’il est impossible pour l’utilisateur de vérifier l’origine ou la qualité d’une réponse.

👉 C’est là le risque majeur : sans références claires, il est impossible d’évaluer la validité juridique.

4. Face à des questions complexes, l’IA “hallucine”

Lorsque les questions deviennent plus complexes, les modèles commencent à inventer des faits ou à simplifier excessivement.

👉 Or ce sont précisément les cas complexes qui exigent une précision juridique maximale.

Que signifie cela pour le travail juridique ?

Cette analyse démontre pourquoi l’IA généraliste n’est pas adaptée aux questions juridiques :

❌ Pas de sources fiables

❌ Aucune garantie d’actualité

❌ Manque total de transparence

❌ Taux élevé d’erreurs et d’hallucinations

En droit, « presque correct » ne suffit pas. Il faut que ce soit correct.

Pourquoi Lawise / Jurilo est différent

✓ Réponses vérifiées basées sur les lois suisses, les commentaires et la jurisprudence du Tribunal fédéral

✓ 0 % d’hallucinations — chaque réponse repose sur des sources juridiques réelles

✓ Références transparentes et traçables

✓ Modèle spécialisé et non un chatbot généraliste

Alors que les IA généralistes fournissent souvent des réponses approximatives, Lawise fournit des réponses correctes, ce qui est indispensable dans le domaine juridique.

Conclusion

L’analyse suisse montre que même pour des questions simples, les modèles d’IA génériques produisent des réponses floues ou incorrectes.

Dans la pratique juridique, cela serait irresponsable.

👉 C’est pourquoi une Legal-AI spécialisée et vérifiée — comme Lawise — est indispensable.

Référence à l’article Watson :

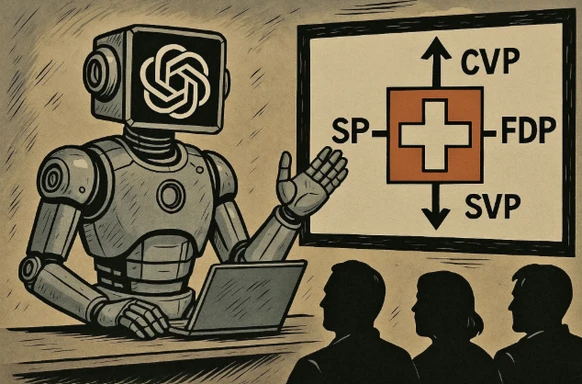

Lorsque nous interrogeons ChatGPT, l’IA explique aussi des sujets complexes de la politique suisse. Mais ses recherches ne sont pas toujours équilibrées ou suffisamment solides.

Image : KI-generiert/ChatGPT/bev